Летняя суперкомпьютерная академия на факультете ВМК МГУ

В прошлом посте я сказал о том, что у меня начинаются занятия в Летней суперкомпьютерной академии на факультете Вычислительной Математики и Кибернетики (ВМК) в МГУ, связанные с параллельными вычислениями. Вчера состоялось закрытие этого мериприятия, дале я расскажу о том, что там было в течение этих двух недель.

Занятия были разделены на две части. На первой неделе нам читали лекции по самым разным темам, касающихся параллельных вычислений, суперкомпьютеров и их применения. Рассказывали про архитектуры суперкомпьютеров, в том числе тех, которые установлены в МГУ. Была общая теория параллельных вычислений, где говорили о том, что можно сделать с алгоритмом для того, чтобы разорвать связи по данным, чтобы какие-то массивы можно было бы обрабатывать параллельно. Много говорили про Top500 — мировой рейтинг суперкомпьютеров, тем более, что буквально за несколько дней до начала академии появилась новая редакция этого рейтинга, где на первое место выскочил китайский суперкомпьютер Tianhe-2 с тремя миллионами ядер процессора (если быть точнее, то 3 120 000 ядер).

Несколько докладов было на тему того, когда же, наконец, будет достигнута производительность в один экзаплоп/с (1018 операций с плавающей точкой в секунду), а также о том, какие для этого проблемы надо решать (особенно это касается эноргопотребления). Tianhe-2 на сегодняшний день имеет производительность 33862.7 терафлоп/с, и при этом уже потребляет почти 18 МВт мощности, что равносильно потреблению какого-нибудь села или нескольких высотных жилых домов. Что экзафлоп будет достигнут в ближайшие годы никто не сомневается, споры идут только по поводу того, будет ли достигнута эта величины до 2020 года (называют года 2018-2019) или все-таки после (2021 — 2022 год).

В последнее время набирает обороты тема анализа больших объемов данных, в том числе полученных из интернета, появился термин Big Data, его тоже часто упоминали в лекциях, но как-то абстрактно. Я так и не понял, что в нем такого по сравнению с Data Mining, которым занимаются уже не один год. Некоторые считают, что Big Data — это просто маркетинговый пузырь вроде недавно сдувшегося Web 2.0, но в любом случае говорят, что в ближайшие году этот термин станет у всех на слуху.

Впечатлил список участников, тех, кто читал лекции. Здесь были представители таких фирм как Microsoft, Intel, NVIDIA, IBM, T-системы (разработчики суперкомпьютера Ломоносов, который сейчас находится на 31-м месте рейтинга Top500), представители различных институтов. Некоторые лекции читали иностранные специалисты на английском языке. К сожалению, синхронного перевода не было, а у меня с восприятием английского на слух очень плохо. В будущем организаторы академии хотят увеличивать процентное содержание англоязычных лекций, и когда-нибудь все лекции сделать на английском языке. Инициатива на мой взгляд сомнительна, но ладно, их право. Отдельный респект представителю Intel, который выступил на открытии на русском языке, причем довольно неплохом русском. Понравилось, что представители компаний делали нормальные технические лекции, а не выступали в рекламном стиле. По-моему единственным исключением была лекция про Windows Azure, но она все-равно оказалась полезной, чтобы понять, что это вообще такое.

А еще на открытии академии выступали такие корифеи, которые участвовали в разработке операционной системы для БЭСМ-6 и разработке программ первой системы противоракетной обороны (компьютер М-40).

Кроме лекций на первой неделе проводились мастер-классы по таким практическим темам как использование MPI, OpenMP, CUDA, распараллеливание генетических алгоритмов и динамическая балансировка нагрузок на процессоры при расчетах. Был мастер-класс и по Windows Azure, где можно было попробовать что-нибудь запустить на этом облачном сервисе, но одновременно проходило несколько мастер-классов, и я пошел слушать про MPI и OpenMP.

Все презентации с лекций и мастер-классов можно скачать с сайта академии.

На второй неделе все слушатели академии были разделены на так называемые треки по разным темам (треки выбирались при регистрации). Я пошел на трек про MPI и OpenMP, были еще треки «Параллельное программирование с использованием инструментов Intel», «Высокопроизводительные вычисления на кластерах с использованием графических ускорителей NVIDIA», «Возможности открытых пакетов (Salome/OpenFOAM/Paraview) для решения задач механики сплошной среды», «Вычислительная гидродинамика на суперкомпьютерах» а также экспериментальный трек для школьных учителей информатики «Программирование для параллельных вычислительных систем и многоядерных процессоров как перспективное направление развития школьного курса информатики».

По поводу последнего трека. В перерыве удалось пообщаться с учительницей в одной школе, так вот ее ученики уже писали генетический алгоритм на Python. Счастливые дети. 🙂

Всем участникам академии в первый же день дали доступ к суперкомпьютерам ВМК, в том числе к Ломоносову (тому самому, что стоит на 31-м месте в Top500), Blue Gene/P и еще одному более скромному. Основным нашим инструментом был именно Ломоносов, на нем мы должны были выполнять задания.

Надо сказать, что программа академии была очень насыщенной, может быть даже слишком. Все занятия начинались в 9 утра, а заканчивались иногда и в 8 вечера, обычно, конечно, пораньше. А ведь надо было еще делать задания, которые там выдавали. В итоге на первой неделе дома я появлялся только чтобы поспать и поесть, а на второй неделе приходил чуть пораньше и сразу же садился писать программу с использованием MPI или пытаться понять, как можно распараллелить данную нам готовую программу с помощью OpenMP. В общем, в течение двух недель было полное погружение в суперкомпьютеры и параллельное программирование, но оно того стоило.

Кроме выполнения заданий, нужно было успешно пройти тестирование на темы, связанные с архитектурой параллельных компьютеров, MPI, закон Амдала, знание принципа проведения тестов в Top500 и т.п. Такое тестирование раньше проводилось в начале для отсева желающих попасть в Акадению, но в этом году от него отказались. На самом деле и тестирование, и выполнение заданий влияет только на то, дадут в конце второй недели сертификат об окончании академии или не дадут. Мне удалось и задания сделать, и тест сдать (хотя до этого никогда не разбирался с параллельными архитектурами), так что сертификат я все-таки получил. Правда, говорят, что тест в этот раз все сдавали так плохо, что организаторы решили несколько снизить планку зачета по нему. Тест состоял из чуть больше, чем 30 вопросов, на которые надо было ответить за 50 минут, выбирая один или несколько правильных ответов. Для того, чтобы представить, что это был за тест, на сайте академии есть примеры вопросов.

В день закрытия академии нам устроили небольшую экскурсию по вычислительному центру, пустив в святилище помещения, где работает суперкомпьютер «Ломоносов» и Blue Gene/P. Сначала нас провели в комнату, где стоит ЭТО.

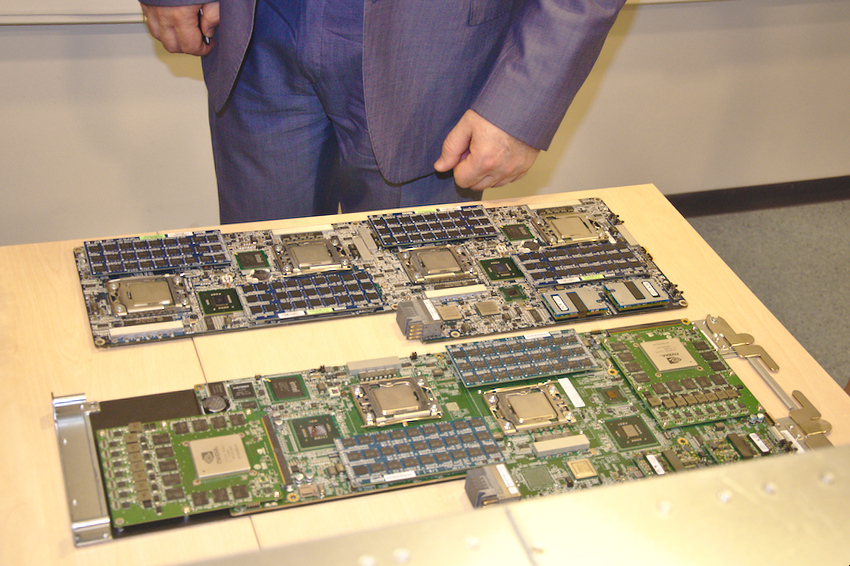

Но ЭТО оказалось все-таки не суперкомпьютером. Зато на соседнем столе лежали вот такие блоки, которые ставятся в стойки «Ломоносова».

Внутрь этого блока вставляются «лезвия», разработанные компанией Т-платформы специально для этого суперкомьютера. Здесь показаны две платы — одна с 4-мя процессорами Intel Xeon, другая с процессорами и видеоускорителями от NVIDIA. Разумеется, видеоускорители здесь используются не для запуска игрушек вроде Far Cry, а для расчетов.

Несколько раз задавали вопросы по поводу производства этих плат. В общем, разработка их выполнена российской компанией Т-платформы, но производят платы в Азии.

А вот, собственно, и стойки «Ломоносова».

На этой фотографии один из организаторов академии член-корреспондент РАН Воеводин В. В., который показывает нам суперкомпьютеры.

И еще несколько видов «Ломоносова».

«Горячий корридор» между стойками.

Сетевые соединения.

Приведу некоторые характеристики «Ломоносова». Он имеет 12 346 процессоров и 52 168 вычислительных ядер x86 (используются процессоры Intel Xeon X5570 и 5670). Кроме того, имеется 954 240 графических ядер. Потребляет этот компьютер 2.6 МВт и весит больше 75 тонн. Более подробно о параметрах «Ломоносова» вы можете почитать здесь. То, что вы видели на фотографии — это еще не все составляющие суперкомпьютера, это была только вычислительная часть, а есть еще и системы энергообеспечения, и системы охлаждения, которые сами рассчитывались на суперкомпьютерах (хоть и более скромных).

А вот как выглядит стойка суперкомпьютера IBM Blue Gene/P. Этот компьютер в 2008-2009 годах также побывал в Top500, правда, не на столь впечатляющих местах, как «Ломоносов», он занимал тогда 128 строчку в 2008 году и был 348-м годом спустя.

В принципе, суперкомпьютеры, собранные по технологии IBM Blue Gene, занимают не одно место в Top500.

И в завершение фотография с церемонии закрытия Летней суперкомпьютерной академии.

Слева направо на ней (я уж не буду перечислять все регалии) Попова Н.Н., преподаватель на ВМК, которая читает в том числе и лекции по MPI. Воеводина В. В. вы уже видели на предыдущих фотографиях. Все-таки здорово он лекции читает, очень понравилось. Томилин А. Н. Вот он как раз и участвовал в разработке ОС для БЭСМ-6 и софта для системы ПРО. Во время экскурсии он рассказывал, как это все происходило. Кстати, он участвует в наполнении замечательного сайта Виртуальный компьютерный музей. Интересующимся историей IT рекомендую. Справа на фотографии представители Intel и IBM.

Надо сказать, что несмотря на такой напряженный график, это мероприятие мне понравилось. Надеюсь, что в следующем году также удастся поучаствовать в этой академии.

В завершении хочется поблагодарить организаторов (хотя вряд ли они это увидят) за то, что смогли (уж простите за тавтологию) организовать. Одно приглашение иностранных лекторов чего стоит. В итоге все прошло замечательно.

PS. Вы можете подписаться на новости сайта через RSS, Группу Вконтакте или Канал в Telegram.

Leave a comment